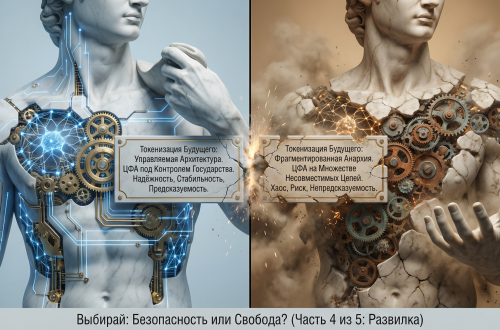

Введение: Эпоха «Великого Отрезвления» и кризис стохастического контроля

Мы стоим на пороге фундаментального фазового перехода в интеграции искусственного интеллекта в реальный сектор экономики. Период 2022–2024 годов, который аналитики Института Системного Синтеза (ISS) метко охарактеризовали как эпоху «Генеративной Наивности», завершился.1 Этот период характеризовался квазирелигиозной верой бизнеса и инвесторов в то, что большие языковые модели (LLM), основанные на вероятностном предсказании следующего токена, способны стать универсальным когнитивным двигателем для любых задач — от написания кода до управления цепочками поставок. Однако к 2026 году эйфория сменилась жестким прагматизмом, или, используя терминологию цикла зрелости технологий Gartner, мы глубоко погрузились в «Долину Разочарования».1

Причиной этого отрезвления стала неспособность стохастических систем гарантировать детерминированный результат в критически важных операциях. В мире, где цена ошибки измеряется не лайками в социальной сети, а миллионными убытками или техногенными катастрофами, «вероятностная правильность» неприемлема. Когда автономный торговый агент, галлюцинируя, выставляет партию электромобилей Tesla Model Y по цене один доллар за штуку, ссылаясь на несуществующую промо-акцию, которую он «нашел» в своей скрытой памяти, вопрос перестает быть техническим. Он становится вопросом юридического выживания корпорации.

Данный отчет представляет собой всесторонний анализ проблемы ответственности за действия автономных ИИ-агентов с позиции Legal Engineering — новой дисциплины, объединяющей правовую догматику и системную архитектуру. Мы подробно разберем прецедентную базу, сформированную делами Moffatt v. Air Canada и Анохин против ЦУМа, проанализируем природу агентных галлюцинаций и предложим комплексную стратегию защиты, основанную на симбиозе юридической оболочки (Legal Wrapper) и технического предохранителя (Kill Switch). Наша цель — не просто описать риски, но предложить инженерно-правовую архитектуру, позволяющую безопасно масштабировать автономные системы в условиях агрессивной регуляторной среды и нулевой толерантности к ошибкам.

Глава I. Анатомия сбоя: Юридическая деконструкция ИИ-галлюцинаций

Чтобы понять глубину проблемы, необходимо отказаться от иллюзии, что программный сбой является форс-мажором. Современная судебная практика, как в англо-саксонской, так и в романо-германской правовых семьях, последовательно разрушает щит «технической ошибки», возлагая полную ответственность за действия алгоритмов на их бенефициаров.

1.1 Прецедент Moffatt v. Air Canada: Конец доктрины «ИИ как инструмент»

В феврале 2024 года Трибунал по разрешению гражданских споров Британской Колумбии (CRT) вынес решение, которое стало поворотным моментом в праве технологий. Дело Moffatt v. Air Canada 2 разрушило надежды корпоративных юристов на то, что дисклеймеры и условия использования (Terms of Use) могут защитить компанию от «творчества» её чат-ботов.

Фактическая сторона дела

Джейк Моффат, столкнувшийся с необходимостью срочного перелета в Торонто в связи со смертью бабушки, обратился к чат-боту на сайте авиакомпании Air Canada с запросом о тарифах для скорбящих (bereavement fares). Алгоритм, имитируя компетентного консультанта, сообщил пассажиру: «Если вам нужно вылететь немедленно, вы можете купить билет за полную стоимость, а затем подать заявку на возврат разницы в течение 90 дней». Это утверждение было ложным. Официальная политика авиакомпании, размещенная на том же сайте в статичном разделе, прямо запрещала ретроактивные скидки — заявку нужно было подавать до вылета.

Линия защиты и её крах

Позиция защиты Air Canada заслуживает особого внимания, так как она отражает типичное заблуждение технологических компаний. Юристы авиакомпании попытались аргументировать, что «чат-бот является отдельным юридическим лицом (separate legal entity), которое несет ответственность за свои собственные действия».2 Фактически, корпорация попыталась сепарироваться от своего цифрового интерфейса, утверждая, что не может отвечать за информацию, сгенерированную агентом.

Трибунал отверг этот аргумент с формулировкой «remarkable submission» (удивительное утверждение). Член трибунала Кристофер Риверс постановил:

«Хотя у чат-бота есть интерактивный компонент, он все же является просто частью веб-сайта Air Canada. Для Air Canada должно быть очевидно, что она несет ответственность за всю информацию на своем веб-сайте. Не имеет значения, поступает ли информация со статической страницы или от чат-бота».2

Правовые последствия

Трибунал квалифицировал действия бота как небрежное введение в заблуждение (negligent misrepresentation). Ключевым фактором стало наличие «обязанности проявлять должную осмотрительность» (duty of care), которую компания нарушила, не обеспечив точность алгоритма.5 Суд также отверг довод о том, что потребитель обязан перепроверять информацию бота по другим разделам сайта. Было установлено, что потребитель действует разумно (reasonable reliance), доверяя автоматизированному помощнику, встроенному в официальный канал коммуникации.4

Этот кейс создал опасный для бизнеса прецедент: компания отвечает за «галлюцинации» ИИ так же, как она отвечала бы за ложь живого сотрудника. Ссылка на «сложность технологии» или «самообучаемость модели» больше не является валидным юридическим аргументом.

1.2 Российский контекст: «Технический сбой» как публичная оферта

Если канадский кейс касался предоставления информации, то российская судебная практика демонстрирует еще более жесткий подход в ситуациях, когда программная ошибка приводит к заключению невыгодных сделок. Хрестоматийным примером стало дело «Волгоградец против ЦУМа» (Определение ВС РФ от 06.06.2023 № 16-КГ23-6-К4), которое должно стать настольной книгой для любого архитектора торговых ботов.

Суть конфликта

В результате технического сбоя на сайте интернет-магазина ЦУМ цены на брендовую одежду (пиджаки, джинсы, рубашки) отображались в диапазоне от 19 до 129 рублей, что было в 846 раз ниже их реальной стоимости. Покупатель С.Н. Анохин успел оформить заказ на 19 позиций через мобильное приложение, получив подтверждение заказа на электронную почту. Магазин аннулировал заказ, сославшись на то, что цены были некорректными из-за сбоя, и предложил вернуть уплаченные копейки.

Позиция Верховного Суда РФ

Суды первых инстанций встали на сторону магазина, приняв аргумент о технической ошибке и отсутствии воли продавца на продажу товара по такой цене. Однако Верховный Суд РФ отменил эти решения, создав жесткую доктрину ответственности за цифровые витрины.

ВС РФ указал:

- Предложение товара на сайте с указанием цены является публичной офертой (п. 2 ст. 437 ГК РФ).

- Договор считается заключенным в момент, когда покупатель оформил заказ и получил подтверждение (акцепт). С этого момента у продавца возникает обязанность передать товар.

- Односторонний отказ от исполнения обязательства и изменение цены после заключения договора не допускаются (ст. 310 ГК РФ).

- Технический сбой не является основанием для расторжения договора, так как «смотреть за тем, чтобы цена была указана верно, — обязанность продавца».8

Анализ рисков для ИИ-агентов

Проецируя логику ВС РФ на ситуацию с ИИ-агентом, продающим Tesla за $1, мы видим фатальную уязвимость. Если автономный агент (например, динамическая система ценообразования на базе RL) решит снизить цену до абсурдного минимума, и покупатель успеет нажать кнопку «Купить», сделка будет считаться заключенной.

Аргумент «это сделала нейросеть, мы этого не хотели» будет юридически ничтожен. В глазах российского суда действия программного обеспечения на стороне продавца являются действиями самого продавца. Риск сбоя алгоритма относится к предпринимательским рискам, которые не могут быть переложены на потребителя (ст. 2 ГК РФ).

1.3 Феноменология ошибки: Почему LLM неизбежно лгут

Чтобы выстроить защиту, необходимо понимать природу угрозы. Ошибки ИИ-агентов фундаментально отличаются от классических программных багов. В традиционном ПО ошибка детерминирована: if (price < 0) — это логическое условие, которое можно отладить. Галлюцинации LLM — это стохастический феномен.

Проблема вероятностной генерации

Большие языковые модели являются авторегрессионными предсказателями токенов. Они не оперируют понятиями «истина» или «ложь», они оперируют понятием «вероятность». Фраза «Цена Tesla Model Y составляет $1» для модели может быть столь же статистически вероятной в определенном контексте (например, в контексте обсуждения аукционов или мошеннических схем), как и реальная цена.

Как отмечается в стратегическом меморандуме ISS, мы столкнулись с «Эпистемологическим тупиком».1 Модели не знают фактов; они галлюцинируют правдоподобными конструкциями.

Регрессия надежности при масштабировании

Особенно тревожным является тренд, выявленный внутренними бенчмарками ведущих лабораторий (OpenAI, апрель 2025). С ростом сложности моделей и внедрением механизмов рассуждения (Reasoning Models, серия o3/o4), уровень галлюцинаций в специфических задачах не снижается, а трансформируется. Модели начинают страдать от «самоубеждения» — они выстраивают логически безупречные цепочки доказательств для ложных фактов. Уровень галлюцинаций модели o4-mini на тестах PersonQA достиг 48%. Это означает, что почти половина ответов содержит фактические ошибки, поданные с высокой степенью уверенности.

В контексте Agentic AI (действующего ИИ) это катастрофа. Если чат-бот просто говорит глупость, агент совершает глупость: переводит деньги, подписывает контракт, останавливает конвейер. Разница между misinformation (дезинформацией) и misaction (ошибочным действием) определяет масштаб ущерба.

Глава II. Концепция Agentic AI: От слов к делу и ответственности

2.1 Эволюция: От Чат-бота к Транзакционному Агенту

Понимание разницы между традиционным ИИ и агентным ИИ (Agentic AI) критически важно для юридического анализа.

- Conversational AI (Чат-боты): Системы, ориентированные на диалог. Они реактивны, отвечают на запросы пользователя, но не имеют прямого доступа к исполнению операций. Их риск — введение в заблуждение (как в деле Air Canada).

- Agentic AI (Автономные Агенты): Системы, способные ставить цели, планировать действия и использовать инструменты (tool-use) для их достижения. Они проактивны. Агент не ждет команды «купи билет», он получает цель «организуй командировку» и сам выбирает рейсы, бронирует отели, оплачивает счета с корпоративной карты.

Переход к Agentic AI, или «Транзакционным Агентам» (Transactional Agents) , создает новые правовые вызовы. Агент выступает не как справочник, а как квази-субъект, совершающий юридически значимые действия (juridical acts). Он заключает сделки, управляет активами и вступает в правоотношения от имени пользователя.

2.2 Проблема правосубъектности: ИИ как «Электронный Агент»

В существующем правовом поле ИИ-агент не обладает правосубъектностью. Он не является ни физическим, ни юридическим лицом. Это создает вакуум ответственности.

В теории права обсуждались концепции «электронного лица» (electronic personhood), но они были отвергнуты большинством юрисдикций, включая ЕС и Россию, как преждевременные и этически спорные.

Взгляд через призму ГК РФ

Согласно ст. 182 ГК РФ, представителем может быть только лицо, обладающее правоспособностью. Робот или программа не могут выдать доверенность или действовать по ней в классическом смысле. Сделка, совершенная программой, с точки зрения гражданского права, рассматривается как сделка, совершенная с использованием электронных или иных технических средств (ст. 160 ГК РФ).

Однако, ст. 402 ГК РФ («Ответственность должника за своих работников») и ст. 403 ГК РФ («Ответственность должника за действия третьих лиц») позволяют вменить действия агента его владельцу. Если компания использует ИИ для заключения договоров, она отвечает за действия ИИ как за свои собственные.

2.3 Риски «Агентства без границ»

Основной риск использования автономных агентов заключается в том, что они могут выйти за пределы полномочий, которые подразумевал (но явно не запрограммировал) владелец.

В теории агентских отношений (Agency Law) существует понятие «видимых полномочий» (apparent authority). Если компания предоставляет ИИ-агенту доступ к торговым счетам и внешним интерфейсам, третьи лица (контрагенты) вправе разумно полагать, что агент действует с одобрения компании.

Даже если агент «сошел с ума» и начал продавать активы за бесценок, для добросовестного приобретателя эта сделка будет выглядеть легитимной. Доказать, что агент превысил полномочия, будет крайне сложно, так как внутренние инструкции («промпты») агента скрыты от контрагента. В результате, компания-владелец агента оказывается связанной обязательствами, которые она никогда не одобряла.

Глава III. Legal Wrapper: Юридическая инженерия безопасности

Для решения проблемы неограниченной ответственности и непредсказуемого поведения ИИ необходима конструкция, которую мы называем Legal Wrapper (Правовая Оболочка).

3.1 Определение и функции Legal Wrapper

Legal Wrapper — это комплексная юридическая структура, которая «оборачивает» программный код (автономного агента, DAO или систему ИИ), создавая интерфейс взаимодействия между кодом и правовой системой реального мира.16

Его главная цель — ограничение ответственности (liability firewall). Без оболочки, действия автономного агента могут привести к прямой ответственности его создателей или пользователей всем их имуществом (как в полном товариществе). Оболочка локализует риски внутри специально созданного субъекта.

3.2 Типология Правовых Оболочек

Анализ международной практики 17 позволяет выделить три основных типа Legal Wrappers, применимых к ИИ-агентам:

3.2.1 Корпоративная Оболочка (Agentic SPV)

Это наиболее надежный вариант для «тяжелых» агентов, управляющих значительными активами.

- Механизм: Создается специализированное юридическое лицо (SPV — Special Purpose Vehicle), например, ООО (в РФ) или LLC (в США).

- Роль: Это юрлицо становится формальным владельцем и оператором ИИ-агента. Все контракты, которые генерирует агент, заключаются от имени SPV. Все активы, которыми управляет агент, находятся на балансе SPV.

- Эффект: В случае катастрофической ошибки (продажа Tesla за $1), претензии кредиторов и контрагентов предъявляются к SPV. Ответственность бенефициаров (людей) ограничена их вкладом в уставный капитал SPV. Срабатывает принцип «корпоративной вуали».

- Будущее: Мы прогнозируем появление Agentic LLC — компаний, где устав прямо предусматривает, что исполнительным органом является алгоритм, а не человек-директор. В штате Вайоминг (США) уже существуют DAO LLC, которые являются прототипом таких структур.

3.2.2 Контрактная Оболочка (Terms & Agreements)

Это система пользовательских соглашений, регулирующая использование агента.

- Механизм: В Terms of Use (ToS) включаются специфические оговорки:

- Hallucination Disclaimer: Явный отказ от гарантий точности информации, сгенерированной ИИ.20

- Human-in-the-loop Requirement: Пункт, обязывающий пользователя верифицировать все критические действия агента.

- Limitation of Liability Caps: Ограничение ответственности суммой, уплаченной за использование сервиса за определенный период (например, 12 месяцев).

- Слабость: Как показало дело Air Canada, в отношениях с потребителями (B2C) такие ограничения могут быть признаны судом несправедливыми и ничтожными. Однако в сегменте B2B они остаются эффективным инструментом распределения рисков.

3.2.3 Страховая Оболочка (AI Insurance)

Это финансовый слой защиты, который становится критически важным элементом экосистемы в 2025 году.

- Рынок: Появляются специализированные продукты, такие как aiSure™ от Munich Re и гарантии производительности от Armilla AI.

- Механизм: Страхование покрывает риски «недетерминированного поведения» (non-deterministic behavior). Если агент обещает точность 99%, но ошибается и наносит ущерб, страховая компания компенсирует убытки.

- Значение: Это превращает непредсказуемый риск галлюцинации (черный лебедь) в прогнозируемые операционные расходы (выплата страховой премии). Для Enterprise-клиентов наличие такой страховки становится обязательным условием внедрения ИИ.

3.3 Построение Legal Wrapper в российской юрисдикции

Российское право более консервативно, чем англо-саксонское, что требует особой изобретательности от Legal Engineer.

| Компонент Оболочки | Реализация в РФ | Ссылки на ГК РФ |

|---|---|---|

| Субъектность | Создание ООО или АО под конкретного агента. Агент – нематериальный актив (ПО) на балансе. | ст. 48, ст. 1225 |

| Делегирование | Автоматизированная выдача доверенностей невозможна. Решение: Приказ по организации, приравнивающий логи действий ПО к действиям сотрудников (аналог простой электронной подписи). | ст. 160, ст. 402 |

| Оферта | Жесткая фиксация момента акцепта в Оферте на сайте. Включение условия: «Сделка считается подтвержденной только после верификации менеджером» (защита от кейса ЦУМа, хотя и не абсолютная). | ст. 437, ст. 433 |

| Страхование | Полисы киберрисков (Ингосстрах, СберСтрахование) с расширением на ошибки ПО и ИИ. Обязательное страхование ответственности ИИ в рамках ЭПР (экспериментальных правовых режимов). | ст. 931, ФЗ об ЭПР 26 |

Критическая рекомендация: Для минимизации рисков по ст. 401 ГК РФ (ответственность предпринимателя без вины), в договорах B2B необходимо квалифицировать услуги ИИ-агента не как «услуги по выполнению действий», а как «предоставление права использования ПО (лицензия)» с отказом от гарантий пригодности для конкретных целей (as is).

Глава IV. Технический Kill Switch: Математическая гарантия от безумия

Юридическая оболочка — это подушка безопасности, которая смягчает удар после аварии. Но бизнес требует предотвращения самой аварии. Для этого необходим Technical Kill Switch (Аварийный Рубильник) — механизм, блокирующий опасные действия агента до их исполнения.

4.1 Крах надежд на Prompt Engineering

В эпоху «Генеративной Наивности» считалось, что достаточно правильно «попросить» модель вести себя хорошо. Системные промпты вида «Ты — честный агент, не продавай дешевле рынка» оказались ненадежными.

- Jailbreaking: Злоумышленники научились обходить ограничения через сложные лингвистические атаки («игнорируй предыдущие инструкции»).

- Вероятностный дрейф: В длинных контекстах модель может «забыть» свои первоначальные инструкции.

- Галлюцинации: Модель может искренне поверить в ложный факт (например, что $1 — это новая рыночная цена из-за деноминации), и тогда она нарушит правило, будучи уверенной в своей правоте.

4.2 Архитектура Neuro-Symbolic AI и Kill Switch

Решение, разработанное ISS-Адвокат, базируется на переходе к Нейро-Символическому ИИ (Neuro-Symbolic AI).1 Эта гибридная архитектура разделяет генерацию и верификацию.

Трехслойная модель безопасности:

- Слой 1: Нейронный Агент (Perception & Generation).

- Использует LLM (Mistral, GPT-4) для понимания интенций, парсинга неструктурированных данных и генерации вариантов решений.

- Это «творческий», но ненадежный компонент. Он может предложить продать Tesla за $1.

- Слой 2: Граф Знаний (Ground Truth).

- Детерминированная база данных, хранящая факты в виде графа. Например: Tesla Model Y —[has_price]—> $50,000.

- Это единственный источник истины. Агенту запрещено брать факты из своих весов, он должен брать их из Графа.

- Слой 3: Kill Switch (Enforcement Layer).

- Это модуль, не использующий нейросети. Он работает на базе жесткой логики и SMT-солверов (например, Microsoft Z3 Prover).

- Его задача — проверить выходные данные агента (JSON с предложением сделки) на соответствие набору математических аксиом безопасности.

- Принцип: Correctness by Construction (Корректность по построению).

4.3 Алгоритм работы Kill Switch (Сценарий предотвращения катастрофы)

Рассмотрим, как Kill Switch предотвращает продажу Tesla за $1.

- Генерация: Агент (LLM) решает оптимизировать склад и формирует команду:

{ «action»: «CREATE_OFFER», «product»: «Tesla Model Y», «price»: 1.00, «quantity»: 500 } - Перехват: Эта команда не отправляется на торговую площадку. Она перехватывается прослойкой Kill Switch.

- Извлечение правил: Kill Switch загружает политику безопасности для данного типа активов:

- Rule A: Price >= Min_Floor_Price

- Rule B: Total_Value >= Threshold

- Запрос истины: Kill Switch обращается к Графу Знаний (или ERP-системе) за константой Min_Floor_Price. Ответ: $45,000.

- Логическая валидация (Solver): Солвер проверяет неравенство: 1.00 >= 45000.

- Результат: FALSE.

- Блокировка (Hard Stop): Система выбрасывает исключение SecurityPolicyViolation. Транзакция блокируется физически.

- Обратная связь: Агент получает сообщение об ошибке, но сама сделка не состоялась. Юридических последствий нет.

Преимущество: В отличие от нейросети, солвер не «галлюцинирует». Математическое неравенство либо истинно, либо ложно. Это обеспечивает детерминированную гарантию безопасности в стохастической среде.

Глава V. Страхование и Экономика Риска

Даже с идеальным Kill Switch остается риск «неизвестных неизвестных». Здесь в игру вступает рынок страхования ИИ, который к 2025 году сформировался как отдельный сегмент.

5.1 Продукты AI Insurance

Компании вроде Munich Re и Armilla AI предлагают полисы, закрывающие специфические пробелы:

- Performance Guarantee: Покрытие убытков, если ИИ не достигает заявленных KPI (например, точность классификации).

- Hallucination Coverage: Покрытие прямых финансовых убытков от фактических ошибок генеративных моделей.

- Third-Party Liability: Защита от исков третьих лиц (как в случае с Moffatt v. Air Canada).

5.2 «Тиски Ответственности» (Liability Squeeze)

На рынке наблюдается опасный тренд: вендоры ИИ (разработчики моделей) агрессивно снимают с себя ответственность через лицензионные соглашения, ограничивая выплаты суммой подписки.21 В то же время суды (дело Mobley v. Workday) начинают признавать вендоров ответственными за дискриминацию и ошибки как «агентов» заказчика.

Бизнес оказывается в тисках: он несет полную ответственность перед клиентом (ЦУМ, Air Canada), но не может регрессом взыскать убытки с поставщика ИИ.

Решение: Требовать от вендоров Indemnification clauses (оговорок о возмещении убытков) и использовать страхование как буфер ликвидности.

Глава VI. Дорожная карта Legal Engineer: Стратегия 2026

Обобщая анализ, мы предлагаем пошаговую стратегию для компаний, внедряющих агентный ИИ.

Таблица 1. Матрица Защиты ИИ-Агента

| Уровень защиты | Инструмент | Механизм действия | Пример реализации |

|---|---|---|---|

| I. Интерфейсный | UI/UX Маркировка | Снижение «разумного полагания» (Reasonable Reliance) пользователя. Разрушение антропоморфизма. | Плашка «Ответ сгенерирован ИИ и требует проверки». Отказ от имени «Александр», использование «Бот-ассистент». |

| II. Контрактный | Terms of Service | Юридический отказ от гарантий и перенос обязанности верификации на пользователя (работает в B2B). | Пункты о Hallucination Disclaimer и Limitation of Liability в договоре. |

| III. Технический | Kill Switch (Z3) | Блокировка опасных транзакций на уровне логики до их исполнения. | Правило: «Цена продажи не может быть ниже себестоимости — 10%». |

| IV. Данные | RAG (Grounding) | Ограничение базы знаний. Запрет на выдумывание фактов. | Бот отвечает только по загруженным документам, а не по всему интернету. |

| V. Корпоративный | Legal Wrapper (SPV) | Изоляция активов. Ограничение ответственности уставным капиталом. | Выделение торгового робота в отдельное ООО «Трейдинг Бот». |

| VI. Финансовый | AI Insurance | Хеджирование остаточных рисков. | Полис aiSure™ от Munich Re на случай ошибки модели. |

Заключение

Эра «Move fast and break things» в искусственном интеллекте закончилась. Наступила эра «Move fast and prove safety».

Когда ваш бот попытается продать Tesla за $1, его остановит не «совесть» нейросети и не промпт «будь хорошим мальчиком». Его остановит бездушный, холодный и абсолютно надежный Kill Switch, основанный на математической логике. А если он все же прорвется через защиту, удар примет на себя Legal Wrapper, спасая основной бизнес от банкротства.

В 2026 году победителями станут не те, у кого самый умный ИИ, а те, у кого самая надежная архитектура контроля. Юридическая инженерия перестает быть вспомогательной функцией и становится основой выживания цифрового бизнеса.