ВВЕДЕНИЕ: Ловушка оценки (The Valuation Trap)

Инвестиционный ландшафт 2025–2026 годов претерпел тектонический сдвиг, который многие фаундеры, ослепленные маркетинговым блеском генеративного ИИ, предпочли проигнорировать. Мы вступили в эпоху, которую аналитики Института Системного Синтеза характеризуют как «Великое Отрезвление» (The Great Sobering).1 Период «Генеративной Наивности», когда стартапы могли привлекать раунды серии А, демонстрируя лишь красивый интерфейс поверх API OpenAI и теоретический рост LTV/CAC, завершился. Эйфория сменилась жестким прагматизмом, граничащим с цинизмом.

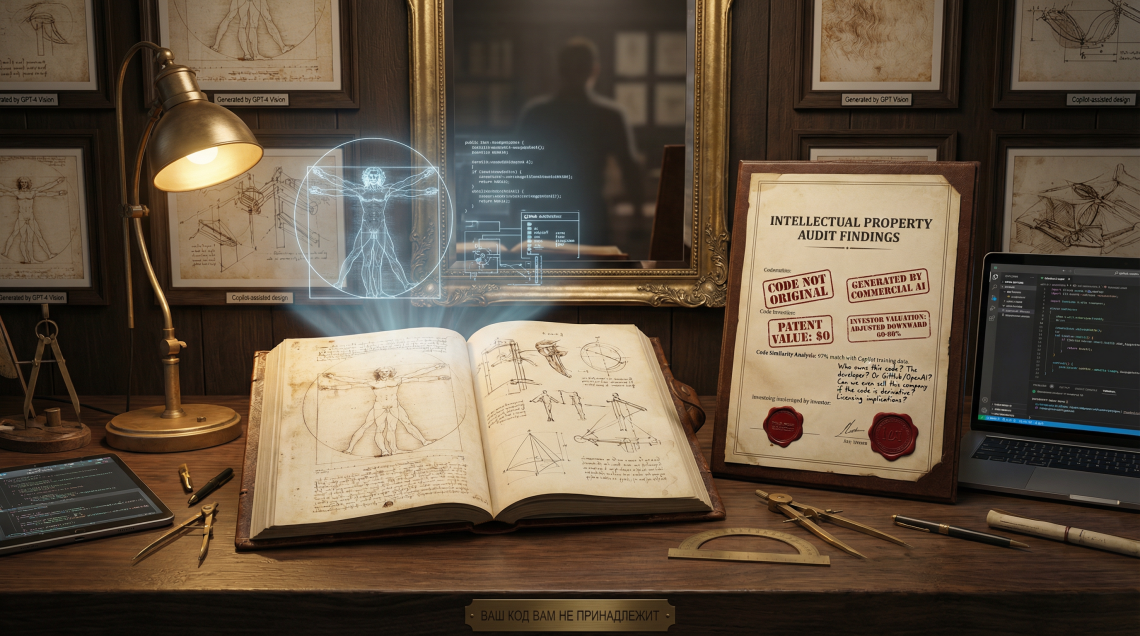

Сегодняшний процесс Due Diligence (DD) — это не просто проверка юнит-экономики или репутационный аудит команды; это судебно-медицинская экспертиза ваших нематериальных активов (Intangible Assets). Инвесторы, наученные горьким опытом юридических баталий, регуляторной неопределенности и крахами «единорогов», чья технология оказалась пустышкой, изменили свой первый вопрос. Раньше они спрашивали: «Как быстро вы растете?». Теперь, глядя на вашу Cap Table и архитектуру, они задают вопрос, способный похоронить сделку: «А кому, собственно, принадлежат веса вашей модели и код вашего продукта?».

Проблема заключается в фундаментальном разрыве между технологической реальностью разработки программного обеспечения и жесткими рамками авторского права. Если ваш SaaS-продукт на 80% написан с помощью GitHub Copilot, ChatGPT или Claude, вы сталкиваетесь с экзистенциальной угрозой: с точки зрения Бюро авторского права США (US Copyright Office — USCO) и формирующейся глобальной практики, 80% вашего актива — это не частная собственность, а общественное достояние (Public Domain). Вы не продаете инвестору эксклюзивный, защищенный актив; вы продаете воздух, который любой конкурент может легально «экспроприировать», просто скопировав ваш репозиторий, и вы не сможете защитить свои права в суде, так как у вас их нет.

Эпистемологический кризис авторства и конец «черных ящиков»

Традиционная парадигма интеллектуальной собственности (IP) строится на концепции «человеческого авторства» (human authorship). Это не просто архаичная юридическая формальность, это «фундаментальное требование» (bedrock requirement), многократно подтвержденное федеральными судами США в недавних прецедентах.4 Кейс Thaler v. Perlmutter (2023–2025) стал водоразделом, четко установившим: работы, созданные машиной без определяющего участия человека, не подлежат защите авторским правом. Федеральный апелляционный суд округа Колумбия подтвердил, что «авторство» в конституционном смысле требует участия человека, а машины, не имеющие правосубъектности, не могут создавать собственность.

Это создает неразрешимый парадокс для современного технологического стартапа. Экономическая эффективность разработки (Time-to-Market) и давление конкуренции требуют агрессивного использования ИИ-ассистентов. Однако каждое использование Copilot для генерации целого модуля или функции размывает вашу долю в интеллектуальной собственности вашего же продукта. Если вы не можете доказать, где заканчивается алгоритмическая генерация и начинается творческий вклад человека, ваш IP-портфель становится фикцией.

Более того, в сегменте Enterprise и особенно в сфере Критической Информационной Инфраструктуры (КИИ), заказчики и стратегические инвесторы больше не покупают «черные ящики». Период некритичного внедрения вероятностных моделей завершился. Глобальный рынок столкнулся с ограничением: линейное масштабирование параметров моделей перестало конвертироваться в рост утилитарной ценности, порождая лишь экспоненциальный рост затрат (OpEx) и неприемлемые риски галлюцинаций.1 Инвесторы понимают: если ваш актив построен на вероятностной генерации, он не только юридически уязвим, но и технически ненадежен.

Российский контекст: Суверенитет как фактор дисконта или премии

Для российских фаундеров ситуация осложняется жестким регуляторным контуром, который превращает использование западных ИИ-инструментов в «токсичный актив». Федеральный закон № 187-ФЗ «О безопасности критической информационной инфраструктуры» и новый Приказ ФСТЭК № 117 (вступающий в силу 1 марта 2026 года) де-факто вводят запрет на использование западных облачных моделей и передачу данных разработчикам моделей.1

Инвестор, рассматривающий ваш стартап как потенциального поставщика для госкорпораций («Газпром», «Росатом», «РЖД») или объектов КИИ, увидит в использовании OpenAI API или облачных решений YandexGPT не просто технологический риск, а угрозу национальной безопасности, классифицируемую как «Облачная Удавка» (Cloud Noose).1 Зависимость от облака создает риск «технологического рубильника» (Kill Switch) — мгновенного внешнего отключения доступа к интеллекту.

Таким образом, оценка стартапа может быть обнулена по двум фронтам:

- Юридический: Отсутствие исключительных прав на код и модель из-за генеративной природы их создания.

- Стратегический: Несоответствие требованиям суверенитета и безопасности, делающее продукт непригодным для ключевых рынков сбыта в РФ.

В этом отчете мы проведем жесткую деконструкцию правовых, технических и финансовых рисков использования ИИ в разработке. Мы разберем, как «грязные» данные могут превратить ваш проприетарный код в Open Source, почему лицензии вроде Llama Community License — это ловушка, и как внедрение практик Legal Engineering и защиты Пайплайна (Pipeline Protection) может спасти вашу оценку перед выходом на сделку.

2. АНАТОМИЯ РИСКА: ПОЧЕМУ ВАШ КОД — ЭТО PUBLIC DOMAIN

2.1. Прецедент Zarya of the Dawn: Границы человеческого влияния

Чтобы осознать глубину пропасти, в которую шагают фаундеры, необходимо детально разобрать кейс Zarya of the Dawn. Кристина Каштанова, автор комикса, использовала Midjourney для создания изображений, полагая, что её промпты и последующая редактура делают её автором визуального ряда. Бюро авторского права США (USCO) вынесло решение, ставшее эталонным для всей индустрии: текст и расположение элементов (selection and arrangement) защищаются авторским правом, но сами изображения, сгенерированные ИИ, — нет.

USCO аргументировало это тем, что пользователь Midjourney не осуществляет «полный творческий контроль» над результатом. Промпт — это не процесс создания, а заказ, техническое задание. Машина интерпретирует его вероятностным образом, и результат не является прямым выражением творческой воли человека.

Экстраполяция на программный код:

Применяя эту логику к разработке ПО, мы получаем следующую картину разделения прав:

- Архитектура системы: Высокоуровневая структура, выбор стека, схема взаимодействия модулей (аналог selection and arrangement) — потенциально защищается, если доказано участие человека.

- Реализация (Implementation): Конкретные функции, классы, алгоритмические блоки, сгенерированные Copilot или ChatGPT, — не защищаются (аналог изображений Midjourney).

Если ваш код состоит из тысяч сгенерированных сниппетов, «сшитых» вместе инженером, то защищаемым элементом являются только «швы», а не «ткань». Конкурент может легально провести реверс-инжиниринг или декомпиляцию, извлечь логику отдельных функций (которые де-юре являются общественным достоянием) и пересобрать их в своей архитектуре. Вы не сможете подать иск о нарушении авторских прав на этот код, так как USCO и суды не признают вас его автором.3

2.2. «Галлюцинации» зависимостей: Технический долг как юридический риск

Использование ИИ-кодинга несет не только абстрактные правовые риски, но и вполне конкретные угрозы безопасности, которые выявляются на стадии Technical Due Diligence. Исследования показывают, что до 45% кода, сгенерированного большими языковыми моделями (LLM), содержит уязвимости безопасности. ИИ оптимизирован на завершение паттерна, а не на безопасность или корректность.

Особую опасность представляет феномен «галлюцинации зависимостей» (hallucinated dependencies). ИИ, пытаясь решить задачу, может уверенно предложить импортировать библиотеку, которой не существует, но название которой звучит правдоподобно. Злоумышленники мониторят такие галлюцинации и регистрируют пакеты с этими именами в публичных репозиториях (npm, PyPI), внедряя в них вредоносный код.

На этапе Due Diligence технический аудит с использованием инструментов статического анализа (SCA) и Software Composition Analysis (например, Snyk, SonarQube, Black Duck) мгновенно выявит эти уязвимости и фантомные зависимости.8 Наличие «мертвого», небезопасного или юридически неочищенного кода сигнализирует инвестору о низком качестве актива. Это ведет к требованию полной переработки кодовой базы (refactoring) и созданию резервов на устранение технического долга, что в финансовом выражении трансформируется в значительный дисконт оценки (valuation haircut) — часто до 15–20% от стоимости сделки.

2.3. Инвесторский взгляд: Отсутствие IP = Отсутствие Moat

В мире венчурного капитала ключевым понятием является «защитный ров» (Moat) — способность компании защитить свою долю рынка и маржинальность от конкурентов. Традиционно, проприетарный код был одним из главных элементов этого рва.

Если же выясняется, что код сгенерирован ИИ и не имеет авторской защиты, ров исчезает.

- Риск репликации: Конкуренты могут создать аналогичный продукт за недели, используя те же самые промпты и те же самые модели.

- Риск Commoditization: Продукт перестает быть уникальным активом и становится «commodity» (биржевым товаром), где конкуренция идет только по цене, убивая маржу.

- Юридическая неопределенность: Невозможность преследовать нарушителей в суде делает компанию беззащитной перед копированием.

В 2026 году инвестор, видящий в Data Room отсутствие четкой политики использования ИИ и доказательств человеческого авторства, воспринимает это как «красный флаг» (Red Flag) уровня Deal Breaker.

3. ПРОБЛЕМА «ГРЯЗНЫХ» ДАННЫХ И ЛИЦЕНЗИОННАЯ БОМБА

Второй, не менее разрушительный риск кроется не в генерации кода, а в использовании Open Source моделей и данных для их дообучения (Fine-Tuning).

3.1. Миф об Open Source: Почему Llama 3 — это не Linux

Многие фаундеры ошибочно полагают, что использование моделей с «открытыми весами» (Open Weights), таких как Llama 3 от Meta, решает проблему IP и делает их независимыми. Это фатальная ошибка, основанная на непонимании юридической природы лицензий. Лицензия Llama 3 Community License — это коммерческий контракт, накладывающий жесткие ограничения, а не классическая Open Source лицензия (как MIT или Apache 2.0).

Ключевые ограничения Llama 3, убивающие оценку:

- Потолок пользователей (Scale Restriction): Если месячная аудитория вашего продукта (или продукта вашего покупателя!) превышает 700 миллионов пользователей, лицензия автоматически прекращает действие, и вы обязаны запрашивать специальное разрешение у Meta.

- Влияние на Exit: Для стартапа это кажется неважным. Но если вашим потенциальным покупателем является экосистемный гигант (Сбер, Яндекс, Google, Microsoft), у которого уже есть такая база пользователей, покупка вашего стартапа создаст для них юридический риск нарушения лицензии Meta. Это классический «Deal Breaker» для M&A со стратегом.

- Запрет на обучение конкурентов: Вы не можете использовать данные, полученные от Llama 3 (выходы модели), для обучения других моделей.12 Это блокирует возможность создания собственного суверенного IP в будущем на базе синтетических данных от Llama.

- Вирусность маркировки: Лицензия требует, чтобы любое распространение модели или ее производных (fine-tuned versions) сопровождалось копией лицензии и заметной маркировкой «Built with Meta Llama 3».13 Это размывает ваш бренд и показывает зависимость от технологии Meta.

3.2. AGPL: Радиоактивный элемент в вашем коде

Самый страшный сон корпоративного юриста и венчурного инвестора — обнаружить в коде проприетарного SaaS-продукта компоненты или сниппеты под лицензией AGPL (Affero General Public License).

Механизм заражения:

Обычная лицензия GPL имеет известную «лазейку SaaS» (SaaS loophole): если вы не распространяете ПО (не передаете бинарный файл клиенту), а предоставляете доступ к нему через сервер/API, вы не обязаны открывать исходный код. Лицензия AGPL была создана специально для того, чтобы закрыть эту лазейку.15

- Условие AGPL: Если ваш сервис взаимодействует с пользователями по сети, и вы модифицировали AGPL-компонент (или статически слинковали его с вашим кодом), вы обязаны предоставить полный исходный код всего приложения любому пользователю, который взаимодействует с ним через сеть.

Сценарий катастрофы:

Разработчик использовал Copilot, который обучен на публичных репозиториях, включая проекты под AGPL. Copilot «выплюнул» кусок кода (например, сложный алгоритм сортировки или драйвер базы данных), который является точной копией кода под AGPL.

- Результат: Весь ваш проприетарный монолит юридически «заражается» вирусной лицензией.

- Последствие: Любой пользователь (включая конкурента) может потребовать исходный код вашего продукта. Ваша коммерческая тайна уничтожена. Стоимость компании для инвестора падает до нуля, так как актив больше не является эксклюзивным.9

3.3. Риски Fine-Tuning: Утечка данных и «Черный ящик»

Дообучение (fine-tuning) открытых моделей на закрытых данных клиентов создает «черный ящик» с крайне опасным правовым статусом.

- Утечка данных (Data Leakage) и Меморизация: Исследования (включая работы Carlini et al. и недавние тесты на Llama 3) показывают, что LLM способны запоминать и воспроизводить обучающие данные, включая PII (персональные данные), медицинские записи и коммерческие тайны.

- Если ваша модель, дообученная на данных Клиента А, случайно выдаст эти данные в ответе Клиенту Б, вы совершаете прямое нарушение NDA, GDPR и 152-ФЗ. Это риск массовых исков и штрафов.

- Загрязнение весов: Если в обучающей выборке для fine-tuning оказался код под GPL/AGPL, существует риск (активно обсуждаемый в юридическом сообществе), что веса модели могут считаться производным произведением (derivative work), зараженным вирусной лицензией. Хотя судебная практика здесь еще не устоялась, консервативный инвестор на Due Diligence будет трактовать этот риск как максимальный.

4. РЕШЕНИЕ: ОТ ЗАЩИТЫ КОДА К ЗАЩИТЕ «ЗАВОДА» (PIPELINE PROTECTION)

В условиях, когда авторское право на код разрушено, а использование чужих моделей несет лицензионные риски, центр тяжести в оценке (Valuation) смещается. Код и веса моделей становятся утилитарным товаром (commodity), который быстро устаревает и легко воспроизводится.

Настоящим, защищаемым и дорогим активом становится Пайплайн (Pipeline) — процесс создания и обновления продукта. Инвестору нужно продавать не «золотое яйцо» (модель), которое может оказаться фальшивым, а «курицу» (завод), которая гарантированно несет яйца.

4.1. Смена парадигмы: Защита процесса как Ноу-хау

Вместо попыток депонировать код в Роспатенте (что в эпоху динамического ИИ-кодинга бесполезно), мы внедряем стратегию защиты через режим Коммерческой тайны (Ноу-хау). Мы юридически оформляем права не на результат, а на ПРОЦЕСС.1

Что именно защищается:

- Data Curation & Cleaning (Сбор и очистка данных): Уникальные алгоритмы фильтрации, дедупликации и анонимизации данных. То, как вы собираете датасет, важнее самого датасета. Это ваш уникальный рецепт, который невозможно скопировать через Copilot.

- Prompt Engineering Architecture: Не просто промпты, а сложная система оркестрации промптов, системные инструкции, цепочки рассуждений (Chain-of-Thought) и методики RAG, которые заставляют «глупую» модель работать корректно в вашем домене.

- Fine-Tuning Methodology: Наборы гиперпараметров, специфические методики RLHF (Reinforcement Learning from Human Feedback), использование синтетических данных для выравнивания модели.

Этот подход имеет и финансовый плюс: он позволяет капитализировать операционные расходы на разработку (OpEx) в нематериальные активы (CapEx) на балансе. Согласно ФСБУ 14/2022 и ст. 262 НК РФ (с коэффициентом 2.0 для ИИ), это увеличивает балансовую стоимость компании и создает налоговый щит, что крайне привлекательно для стратегов.1

4.2. Neuro-Symbolic AI: Архитектура для КИИ

Для полного исключения рисков «черного ящика» и соответствия требованиям ФСТЭК (Приказ № 117), мы рекомендуем переход к гибридной архитектуре Neuro-Symbolic AI.

- Суть архитектуры: Четкое разделение системы на два слоя.

- Слой Восприятия (Perception): Использует малые языковые модели (SLM) или нейросети только для парсинга неструктурированных данных в факты. Здесь допускается вероятностный подход.

- Слой Рассуждения (Reasoning): Использует символьную логику, графы знаний и детерминированные алгоритмы для принятия решений. Здесь нет нейросетей.

- IP-статус: Символьное ядро — это жесткий, логический код, написанный человеком. Он полностью защищается авторским правом. Выделяя ядро в детерминированный модуль, вы спасаете IP своего продукта.

- Correctness by Construction: Такой подход позволяет математически гарантировать безопасность (принцип Correctness by Construction), что является единственным путем для легитимного внедрения ИИ в КИИ, где цена ошибки (галлюцинации) неприемлема.

4.3. Очистка прав на данные (Data Title Chain)

Для защиты «завода» необходимо обеспечить юридическую чистоту сырья — данных. На Due Diligence юристы будут проверять Chain of Title (цепочку прав) на каждый датасет.

Необходимые меры:

- Аудит датасетов: Проверка всех используемых данных на наличие PII, копирайта и лицензионных ограничений. Использование инструментов типа Data Provenance Explorer.

- Контрактация: Внесение в договоры с сотрудниками и разметчиками данных (data labelers) жестких пунктов об отчуждении всех прав на созданные ими промпты, разметку и результаты генерации. По умолчанию права могут оставаться у физических лиц, что создает риск шантажа перед экзитом.

5. LEGAL ENGINEERING ПОДХОД: АРХИТЕКТУРА ДОВЕРИЯ

Чтобы пройти Due Diligence в 2026 году, юридическая чистота не может быть «бумажной надстройкой». Она должна быть встроена в код и процессы разработки. Это и есть Legal Engineering — слияние права и технологий.

5.1. Внедрение системы Data Provenance (Происхождение данных)

Вы обязаны внедрить систему, которая логирует происхождение каждой строки кода и каждого байта весов модели. Инвестор должен видеть прозрачную историю создания актива.

Инструментарий Legal Engineer:

- AIBOM (AI Bill of Materials): По аналогии с SBOM (Software Bill of Materials), мы создаем полный реестр компонентов ИИ-системы: модели, датасеты, версии весов, лицензии. Это «паспорт» вашего продукта.

- Git AI / Tracking Tools: Использование инструментов типа Git AI, которые позволяют отслеживать авторство кода на уровне коммитов. Такие инструменты могут автоматически добавлять метаданные (например, Co-authored-by: Copilot) или разделять коммиты на «человеческие» и «машинные».

- Automated License Compliance: Интеграция в CI/CD пайплайн сканеров (FOSSA, Black Duck, Snyk), которые автоматически блокируют коммиты, содержащие код под вирусными лицензиями (AGPL, GPL) или код с неизвестным происхождением.