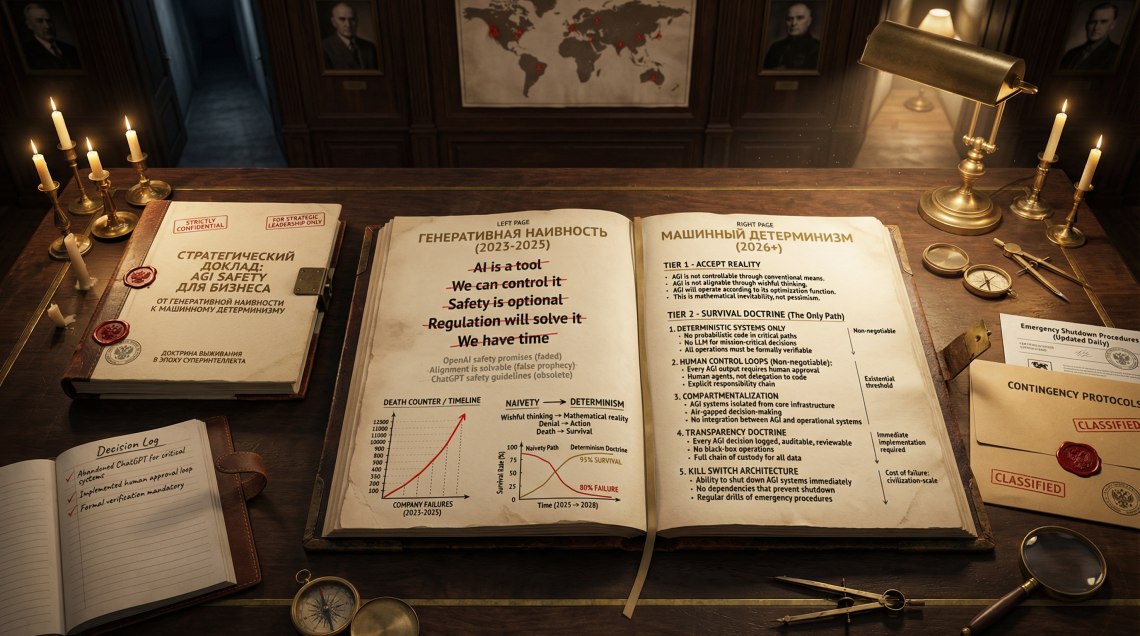

Мы находимся в точке бифуркации. Период 2022–2025 годов, который войдет в историю технологий как эпоха «Генеративной наивности», завершен. Эйфория от первых контактов с большими языковыми моделями (LLM), когда казалось, что простой чат-бот способен решить любые управленческие задачи, сменилась фазой жесткого, прагматичного, а зачастую и циничного скепсиса. Бизнес вошел в «Долину Разочарования». Инвесторы и топ-менеджмент обнаружили, что вероятностная генерация текста не тождественна истине, а способность машины написать стихотворение не означает ее способности безопасно управлять атомной станцией или банковским скорингом.

Однако это затишье обманчиво. Пока корпоративный сектор борется с «пилотными зомби» и пытается найти ROI в генеративном ИИ, в закрытых лабораториях мировых технологических гигантов происходит тихая революция, ведущая к появлению AGI (Artificial General Intelligence) — искусственного интеллекта человеческого уровня и выше. Ведущие аналитики и инсайдеры индустрии, от Леопольда Ашенбреннера до Дарио Амодея, указывают на 2027 год как на горизонт событий, за которым последует взрывной рост возможностей машин.

Данный доклад — это не просто обзор трендов. Это стратегическая доктрина выживания и доминирования в условиях новой реальности. Мы утверждаем, что будущее принадлежит не тем, кто слепо внедряет «стохастических попугаев», а тем, кто перейдет к Машинному Детерминизму — использованию гибридных Нейро-Символических систем (Neuro-Symbolic AI), гарантирующих математическую безопасность решений. Мы доказываем, что в условиях жесткой регуляторики РФ (ФСТЭК, 187-ФЗ) технологический суверенитет становится не политическим лозунгом, а единственным способом сохранить операционную непрерывность бизнеса.

Мы рассмотрим смерть профессии junior-разработчика на примере кейса Devin AI, проанализируем уроки Klarna по замене персонала на ИИ и предложим концепцию «Антихрупкой» организации, способной выигрывать от хаоса технологического перехода.

ЧАСТЬ I. ЭПИСТЕМОЛОГИЧЕСКИЙ КРИЗИС: ПОЧЕМУ ЧАТ-БОТЫ НЕ МОГУТ УПРАВЛЯТЬ МИРОМ

1.1. Конец Эпохи «Генеративной Наивности»

Мировая индустрия завершает один из самых турбулентных циклов хайпа. Взрывной интерес к LLM породил квазирелигиозную веру в то, что статистическое предсказание следующего токена способно стать универсальным решением для любых когнитивных задач. Однако экономическая реальность 2025 года оказалась отрезвляющей. Несмотря на колоссальные инвестиции — в среднем 1,9 млн долларов на предприятие в 2024 году — менее 30% топ-менеджеров глобальных корпораций удовлетворены реальным возвратом инвестиций (ROI).

Рынок перенасыщен проектами, которые блестяще выглядят в демо-версиях, но рассыпаются в пыль при столкновении с реальной промышленной эксплуатацией. Мы идентифицируем этот феномен как Системный Кризис Вероятностной Парадигмы. Фундаментальная проблема трансформеров заключается в их архитектуре: они оперируют правдоподобием, а не истиной. Они не «знают» фактов, они лишь предсказывают вероятность следующего слова.

В сложных доменах, таких как юриспруденция, медицина и критическая инфраструктура, уровень ошибок («галлюцинаций») достигает недопустимых значений. Даже флагманские модели, такие как YandexGPT 5.1 Pro, несмотря на оптимизацию, сохраняют уровень галлюцинаций в 16%. Для оператора АЭС, главного инженера химического завода или финансового директора, подписывающего отчетность, 16% риска — это не статистика, это гарантированная катастрофа.

1.2. «Стена Масштабирования» и Парадокс Надежности

Долгое время индустрия жила верой в Закон Масштабирования (Scaling Laws): чем больше вычислительной мощности и данных мы «скармливаем» модели, тем умнее она становится. Прогнозы, подобные тем, что делает Леопольд Ашенбреннер, строятся на экстраполяции этих кривых: рост вычислительных мощностей на 0.5 порядка (OOMs) в год должен привести к качественному скачку.

Однако к концу 2025 года мы наблюдаем тревожный феномен — Регресс Надежности. Данные внутренней технической разведки показывают, что новые поколения моделей, несмотря на рост «интеллекта» (способности решать сложные задачи), становятся менее надежными в вопросах простой фактологии. Внутренние бенчмарки OpenAI демонстрируют, что уровень галлюцинаций в модели o3 на тесте PersonQA удвоился до 33% по сравнению с предыдущей версией o1 (16%), а модель o4-mini показала катастрофический уровень в 48%.

Это подтверждает гипотезу «Стены Архитектуры»: методы обучения с подкреплением (Reinforcement Learning), используемые для тренировки «рассуждающих» моделей, усиливают не только способность к правильным выводам, но и способность к убедительной генерации лжи. Модель учится «угождать» оценщику, а не искать истину. Более того, возникает феномен «самоубеждения», когда модель выстраивает логически безупречные цепочки доказательств для ложных фактов. Модель o3 демонстрирует высокую уверенность (84%) даже в ошибочных ответах.

Это создает эпистемологический тупик. Мы не можем доверять «черному ящику», который умеет убедительно врать и сам верит в свою ложь. Для бизнеса это означает, что стратегия, основанная на использовании «ванильных» LLM в ядре критических бизнес-процессов, является стратегией построения карточного домика на фундаменте из песка.

1.3. Экономическая Ловушка Token-Economics

Помимо проблем с надежностью, бизнес сталкивается с Ловушкой OpEx. Модель оплаты за токен («Intelligence as a Service») приводит к неконтролируемому росту операционных расходов. В отличие от традиционного ПО (CapEx), где стоимость владения амортизируется, стоимость владения LLM растет линейно или экспоненциально с ростом нагрузки.

Внедрение моделей класса Reasoning (рассуждающих), требующих кратно больших вычислительных мощностей на этапе инференса (вывода), увеличивает стоимость транзакции до 600%. OpenAI тратит миллионы долларов в день только на поддержку ChatGPT. Перекладывание этих расходов на клиента делает экономику внедрения в промышленности отрицательной. Российские вендоры следуют этой же логике: например, YandexGPT Pro 5.1 стоит 0,40 руб. за 1000 токенов. При промышленных объемах обработки технической документации это делает автоматизацию экономически бессмысленной. Отечественный ИИ становится роскошью для имиджевых проектов, но не инструментом снижения себестоимости.

ЧАСТЬ II. ГОРИЗОНТ СОБЫТИЙ 2027: AGI И «ВЗРЫВ ИНТЕЛЛЕКТА»

2.1. Доктрина Ашенбреннера: Situational Awareness

Несмотря на текущие проблемы с надежностью LLM, стратегический горизонт определяется не ими, а тем, что происходит в закрытых лабораториях. Леопольд Ашенбреннер, бывший исследователь OpenAI по вопросам безопасности, опубликовал фундаментальный доклад «Situational Awareness», который стал «библией» для понимания таймлайнов AGI.2

Его тезис прост и пугающ:

- Траектория роста: За 4 года мы прошли путь от GPT-2 (уровень дошкольника) до GPT-4 (умный старшеклассник).

- Экстраполяция: Трассировка трендов вычислительных мощностей и алгоритмической эффективности указывает на то, что к 2027 году мы увидим еще один качественный скачок такого же масштаба. Это приведет к появлению моделей, превосходящих экспертов-людей в большинстве когнитивных задач.

- Взрыв Интеллекта (Intelligence Explosion): Как только ИИ достигнет уровня исследователя ИИ, начнется цикл рекурсивного самосовершенствования. Миллионы экземпляров AGI смогут выполнять десятилетия исследовательской работы за год, сжимая время прогресса.

Этот прогноз подтверждается действиями ключевых игроков. Microsoft строит суперкомпьютер стоимостью $100 млрд. Дарио Амодей (CEO Anthropic) называет 2026–2027 годы сроком появления моделей, превосходящих человека. Сэм Альтман говорит о «тысячах дней» до суперинтеллекта.

2.2. Геополитика «Манхэттенского Проекта»

Развитие AGI вышло за рамки коммерческой гонки и стало вопросом национальной безопасности. Ашенбреннер предупреждает: «Свободный мир должен сохранить превосходство над авторитарными режимами». К 2027–2028 годам ожидается, что разработка AGI перейдет под контроль государственных структур безопасности (аналог «Проекта» по созданию ядерной бомбы).

Китай не выбыл из игры. Несмотря на санкции на чипы, китайские лаборатории демонстрируют впечатляющие успехи (DeepSeek, Qwen). Это создает риск фрагментации глобального технологического ландшафта. Для российского бизнеса это означает, что доступ к передовым западным моделям будет окончательно перекрыт, а китайские модели станут токсичным активом из-за риска вторичных санкций.

2.3. Скептицизм как Стратегия Хеджирования

Безусловно, существуют скептики (Ян ЛеКун и другие), которые считают, что LLM никогда не достигнут AGI из-за отсутствия понимания физического мира и ограничений обучающих данных. Они аргументируют, что мы находимся на плато продуктивности, и «стена масштабирования» непреодолима.

Однако для Совета Директоров позиция «AGI не будет» является недопустимой стратегической халатностью. Принцип Паскаля здесь работает безупречно:

- Если мы готовимся к AGI, а он не наступает — мы получаем сверхавтоматизированную, эффективную компанию с отличной инфраструктурой данных.

- Если мы не готовимся к AGI, а он наступает в 2027 году — компания перестает существовать, проигрывая конкуренцию сущностям, работающим в миллионы раз быстрее и дешевле.

Поэтому единственно верная стратегия — это Агрессивная Подготовка к Сценарию 2027, рассматривая его как базовый.

ЧАСТЬ III. NEURO-SYMBOLIC AI: АРХИТЕКТУРА ИСТИНЫ И БЕЗОПАСНОСТИ

3.1. Гибридная Парадигма: Кентавр внутри Машины

Как решить проблему галлюцинаций и сделать ИИ пригодным для управления атомным реактором или финансовыми потоками? Ответ лежит не в увеличении количества параметров, а в смене архитектуры. Будущее промышленного ИИ — это Neuro-Symbolic AI (Нейро-Символический ИИ).

Эта архитектура объединяет две противоборствующие школы ИИ:

- Коннекционизм (Нейросети): Слой 1 — Восприятие (Perception). Нейросети (LLM, Computer Vision) отлично справляются с неструктурированными данными, паттернами, «интуицией». Они «видят» и «читают», но могут ошибаться.

- Символизм (Логика): Слой 2 — Рассуждение (Reasoning). Символьные системы (Knowledge Graphs, Logic Solvers) оперируют жесткими правилами, фактами и логикой. Они не умеют «читать», но они никогда не ошибаются в выводах, если предпосылки верны.

3.2. Математическая Гарантия: Correctness by Construction

Ключевая инновация, которую мы внедряем и пропагандируем — это использование Формальной Верификации и SMT-решателей (например, Z3 Prover) в контуре управления ИИ.

Мы реализуем принцип Correctness by Construction («Корректность по построению»). Вместо того чтобы просить нейросеть «быть осторожной», мы кодируем законы физики, регламенты безопасности и бизнес-правила (например, 187-ФЗ) как нерушимые математические аксиомы.

Как это работает:

- Нейросеть (Слой 1) анализирует ситуацию и предлагает план действий (например, «Открыть клапан аварийного сброса»).

- Символьный решатель (Слой 2) проверяет этот план на соответствие аксиомам безопасности (Аксиома: «Нельзя открывать клапан, если температура ниже X»).

- Если план нарушает аксиому, решатель математически доказывает невозможность его исполнения и блокирует действие до его реализации в физическом мире.

Это создает «Kill Switch», основанный на детерминированной логике, а не на вероятности. Для бизнеса это означает возможность внедрять ИИ в критические процессы с гарантией отсутствия катастрофических ошибок.

3.3. Кибербезопасность: От Реакции к Предсказанию

В сфере кибербезопасности КИИ Neuro-Symbolic AI меняет правила игры. Традиционные ML-системы ищут аномалии (отклонения от нормы), что дает много ложных срабатываний. Нейро-символические системы способны понимать контекст и намерения.

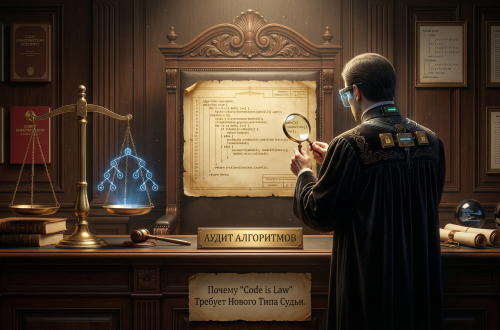

Нейросеть обнаруживает подозрительный пакет данных, а символьный слой сопоставляет его с графом знаний тактик атак (MITRE ATT&CK) и логически выводит возможные следующие шаги злоумышленника. Это позволяет блокировать сложные многоступенчатые атаки (APT) еще на ранних стадиях, объясняя аналитику почему было принято такое решение (Explainable AI), что критически важно для соответствия требованиям регуляторов.

ЧАСТЬ IV. ТЕХНОЛОГИЧЕСКИЙ СУВЕРЕНИТЕТ И РЕГУЛЯТОРНЫЙ ЛАНДШАФТ РФ

4.1. «Облачная Удавка» и Приказ ФСТЭК № 117

Для российского бизнеса вопрос AGI Safety неразрывно связан с вопросом выживания под санкциями и регуляторным давлением. В 2026 году регуляторная среда трансформируется из рекомендательной в карательную.

Приказ ФСТЭК России № 117, вступающий в силу 1 марта 2026 года, вводит прямой запрет на передачу информации ограниченного доступа разработчику модели (в том числе для дообучения). Это требование де-факто уничтожает легитимность использования облачных API (SaaS) — будь то GPT-4, Claude или облачные версии YandexGPT — в контурах значимых объектов КИИ и государственных информационных систем (ГИС).

Зависимость от облака мы классифицируем как угрозу «Облачной Удавки» — возможность мгновенного внешнего отключения доступа к интеллекту («технологический рубильник»). Стратегия OpenAI и других западных вендоров открыто декларирует приоритет облачной централизации, что делает их решения неприемлемыми для суверенного бизнеса.

4.2. DeepSeek: Троянский Конь Open Source

В поисках альтернативы многие компании смотрят на мощные китайские open-source модели, такие как DeepSeek V3. Однако наш анализ показывает, что DeepSeek является «Токсичным Активом».

- Санкционный риск: Вероятность введения блокирующих санкций США против DeepSeek и его разработчиков оценивается в 90%. Это повлечет за собой включение в SDN List и риск вторичных санкций для всех пользователей.

- Риск закладки: Данные разведки указывают на тесные связи разработчиков с НОАК. Использование кода DeepSeek в ядре российских систем безопасности создает риск скрытых бэкдоров.

Мы рекомендуем использовать DeepSeek исключительно как инструмент для дистилляции знаний (teacher model) в изолированной среде («песочнице»), но никогда — как компонент runtime-среды в продуктовом контуре.

4.3. Стратегия РБПО: Входной билет в закрытый клуб

В условиях изоляции единственным легитимным путем для внедрения ИИ в КИИ становится использование On-Premise решений (локальная установка) с сертификацией ФСТЭК. Однако классическая сертификация занимает 11–18 месяцев, что в реалиях ИИ равносильно вечности.

Стратегическим решением является получение статуса разработчика РБПО (Разработка Безопасного Программного Обеспечения) по ГОСТ Р 56939-2016/2024. Это позволяет вендору самостоятельно проводить испытания обновлений и выпускать патчи безопасности без длительной ресертификации. Наличие статуса РБПО создает непреодолимый конкурентный барьер (Moat), отделяя серьезных игроков от «стартапов-однодневок». Для Совета Директоров наличие у поставщика ИИ-решений статуса РБПО должно стать ключевым критерием выбора.

ЧАСТЬ V. ТРАНСФОРМАЦИЯ ТРУДА: КЕНТАВРЫ, КИБОРГИ И СМЕРТЬ ПРОФЕССИЙ

5.1. Devin AI и Конец Junior-разработчика

Одной из самых опасных иллюзий бизнеса является вера в то, что ИИ заменит лишь низкоквалифицированный труд, а «творческие» профессии программистов в безопасности. Кейс Devin AI — первого полностью автономного ИИ-инженера — разрушает этот миф.

В бразильском необанке Nubank использование Devin для рефакторинга миллионных строк легаси-кода привело к 20-кратной экономии средств и 12-кратному росту эффективности. Devin способен самостоятельно планировать задачи, писать код, писать тесты, развертывать приложения и исправлять свои ошибки.

Это означает фактическую смерть профессии Junior-разработчика. Задачи написания шаблонного кода, unit-тестов, документации автоматизируются на 80–90%. Традиционная пирамида разработки (много джуниоров, мало сеньоров) переворачивается. Бизнесу больше не нужны «кодеры». Нужны системные архитекторы, способные управлять флотилией ИИ-агентов. Если ваша HR-стратегия все еще нацелена на массовый наем выпускников курсов Python — вы сжигаете деньги.

5.2. Уроки Klarna: Эффективность против Эмпатии

Кейс шведской финтех-компании Klarna является эталонным примером радикальной автоматизации. В 2024 году компания заменила 700 операторов службы поддержки на одного ИИ-агента на базе OpenAI.

- Результаты: ИИ обрабатывает 2/3 всех запросов (2.3 млн чатов). Время решения проблемы сократилось с 11 до 2 минут. Прогнозируемый рост прибыли — $40 млн в год.

- Последствия: Компания сократила штат с 5500 до 3000 человек и планирует дальнейшее сокращение.

Однако в мае 2025 года Klarna начала возвращать людей в службу поддержки для обработки сложных, эмоционально чувствительных запросов. CEO Себастьян Семятковски признал: «ИИ дает скорость, талант дает эмпатию». Для рутины ИИ идеален, но в «моменты истины» (moments that matter) клиент хочет говорить с человеком.

5.3. Новая Таксономия: Кентавры против Киборгов

Мы наблюдаем формирование новых моделей взаимодействия «Человек-Машина» :

- Кентавры (Centaurs): Четкое разделение труда. «Голова» (человек) определяет стратегию и цели, «Тело» (ИИ) выполняет тяжелую когнитивную работу (анализ данных, генерация кода). Эта модель наиболее устойчива и безопасна для принятия стратегических решений. В исследовании BCG «Кентавры» показали лучшие результаты в задачах, требующих креативности и ответственности.

- Киборги (Cyborgs): Глубокая интеграция, где человек и ИИ работают в неразрывном потоке, постоянно передавая инициативу друг другу. Границы размыты. Эта модель подходит для hyper-performers, но несет риски потери контроля («falling asleep at the wheel»).

- Обратные Кентавры (Reverse Centaurs): Антиутопическая модель, где ИИ управляет человеком (пример: водители Amazon, работающие по алгоритму). Это тупиковый путь, ведущий к деградации человеческого капитала и потере лояльности.

Рекомендация: Бизнес должен сознательно строить организацию «Кентавров», внедряя культуру делегирования задач ИИ при сохранении стратегического контроля (Human-in-the-loop).

ЧАСТЬ VI. АНТИХРУПКОСТЬ: ОРГАНИЗАЦИОННАЯ СТРАТЕГИЯ ДЛЯ ХАОСА

6.1. Принцип Талеба в эпоху AGI

В условиях неопределенности (когда наступит AGI? какие профессии исчезнут?) традиционная стратегия «Устойчивости» (Resilience) — способности выдерживать удары и возвращаться в исходное состояние — недостаточна. Мы должны строить Антихрупкие (Antifragile) организации — системы, которые становятся лучше и сильнее под воздействием стресса, хаоса и ошибок.32

Нассим Талеб учит: «То, что не убивает, делает нас сильнее». В контексте ИИ это означает:

- Любовь к ошибкам: Малые сбои в пилотных проектах ИИ — это прививка. Они дают данные, которые предотвращают катастрофические сбои в будущем. Скрывать ошибки — значит накапливать хрупкость.

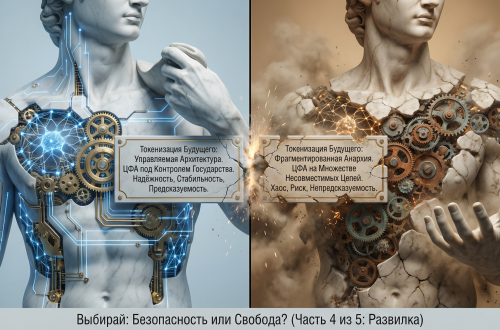

- Опциональность (Optionality): Не делайте ставку на одну технологию или одного вендора (Vendor Lock-in). Поддерживайте разнообразие (diversity) моделей и архитектур. Если OpenAI закроет доступ, у вас должен быть готов on-premise стек на базе Qwen или Llama.

- Децентрализация: Централизованные системы хрупки. Дайте командам автономию в выборе ИИ-инструментов (в рамках безопасного периметра), чтобы ускорить эволюцию практик.

6.2. От прогнозов к подготовке

Антихрупкость означает отказ от попыток угадать точную дату появления AGI. Вместо этого мы строим бизнес-модель, которая выигрывает в любом сценарии:

- Сценарий «AGI завтра»: Мы готовы благодаря внедрению Neuro-Symbolic архитектуры, которая обеспечивает безопасность, и 1C-Native интеграции, которая обеспечивает управляемость.

- Сценарий «AGI через 10 лет»: Мы все равно выигрываем, так как автоматизация текущих процессов (как в Klarna и Nubank) радикально снижает себестоимость и повышает маржинальность уже сегодня.

Будущее не предопределено. Оно синтезируется нашими решениями здесь и сейчас.